MEGAZONEブログ

AWS re:Invent 2024 セッションレポート #AIM110-S|AWS上のNVIDIAアクセラレーション・コンピューティング・プラットフォーム(sponsored by NVIDIA)

NVIDIA accelerated computing platform on AWS (sponsored by NVIDIA)

セッション概要

- タイトル:NVIDIA accelerated computing platform on AWS (sponsored by NVIDIA)

- 日付:2024年12月3日(火)

- Venue:Wynn | Convention Promenade | Latour 2

- スピーカー:

- Dave Salvator(Director Accelerated Computing Products, NVIDIA)

- 業界:Cross-Industry Solutions

- 概要:最新のブラックウェル、ホッパー、エイダラブレースプラットフォームを備えたAWSでコンピューティングを加速したNVIDIAが、作成AIワークロードの問題をどのように解決するかをご覧ください。このセッションでは、20,736個のNVIDIAブラックウェルGPUと10,368個のNVIDIA Grace CPUに拡張されるNVIDIA GB200 NVL72を搭載したスーパーコンピュータープロジェクトセイバーを紹介し、エラスティックファブリックアダプター(EFA)ネットワーキングと最先端の液体冷却ソリューションパフォーマンスを提供することによって優れたパフォーマンス、効率性、スケーラビリティを実現します。また、Blackwell暗号化とAWSニトロシステム、AWS KMS、およびEFAを統合して、エンドツーエンドの暗号化データ保護を保証するセキュリティソリューションのデモをご覧ください。このプレゼンテーションは、AWSパートナーNVIDIAによって提供されます。

はじめに

AWSとNVIDIAが協力して提供するNVIDIAアクセラレーションコンピューティングプラットフォームをテーマにしたセッションを聞き、そのコア技術と革新的なアップデートがあるのか気になってセッションを聞くようになりました。特に注目すべきことは、NVIDIAの最新のGPUアーキテクチャであるBlackwell、AWSとの強力な統合サービス、そして持続可能性のための新しいアプローチだという。

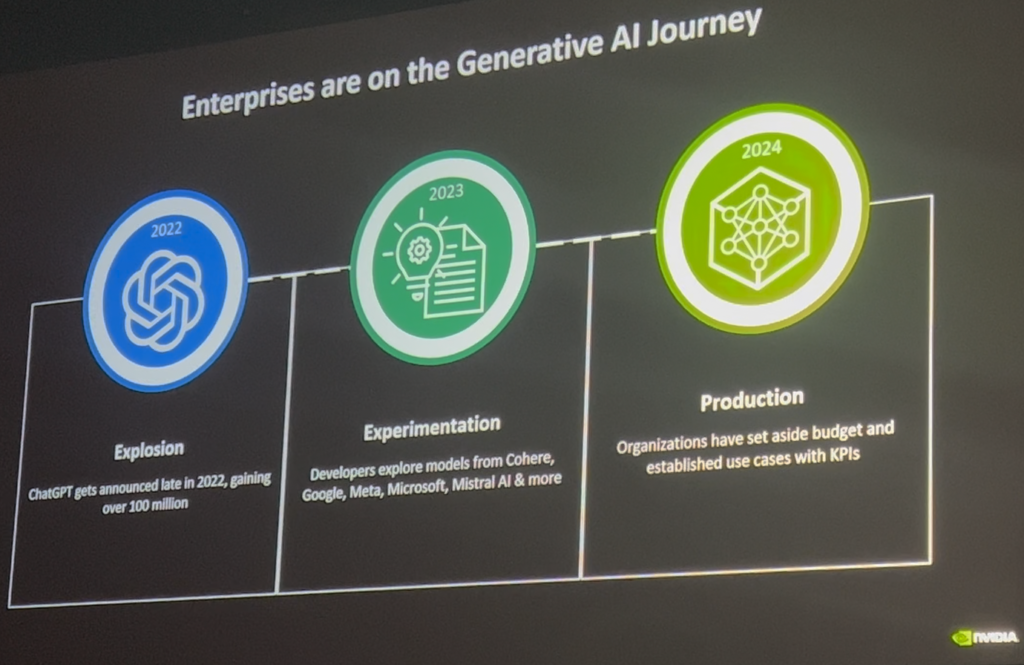

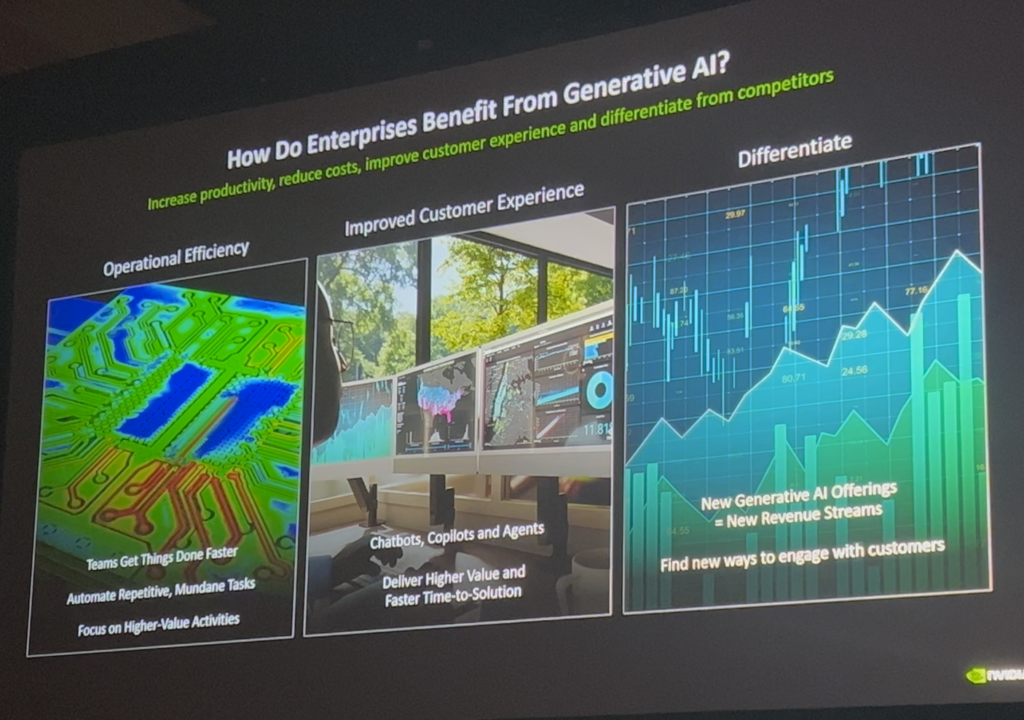

生成型AIの発展と導入

生成型AIは単なる技術的なトレンドを超え、企業の中核的なビジネスツールとして定着していることはよく知られています。NVIDIAは強力なコンピューティングパワーと効率的なアーキテクチャを通じて様々なAI応用事例を支援しており、AWSはこれを簡単に展開し、運営することができる環境を提供しているそうです。 例えば、AIベースの顧客サポートシステムは、大規模な顧客データを分析してカスタマイズされた回答を提供し、企業の効率を高めることに貢献し、特にNVIDIAとAWSの協力は、既存のAIモデルの実験段階を超え、実際のビジネス環境で効果的に適用できる基盤を提供しているそうです。 これにより、顧客体験の改善、ビジネスの差別化、コスト削減などの目標を達成していると話しています。

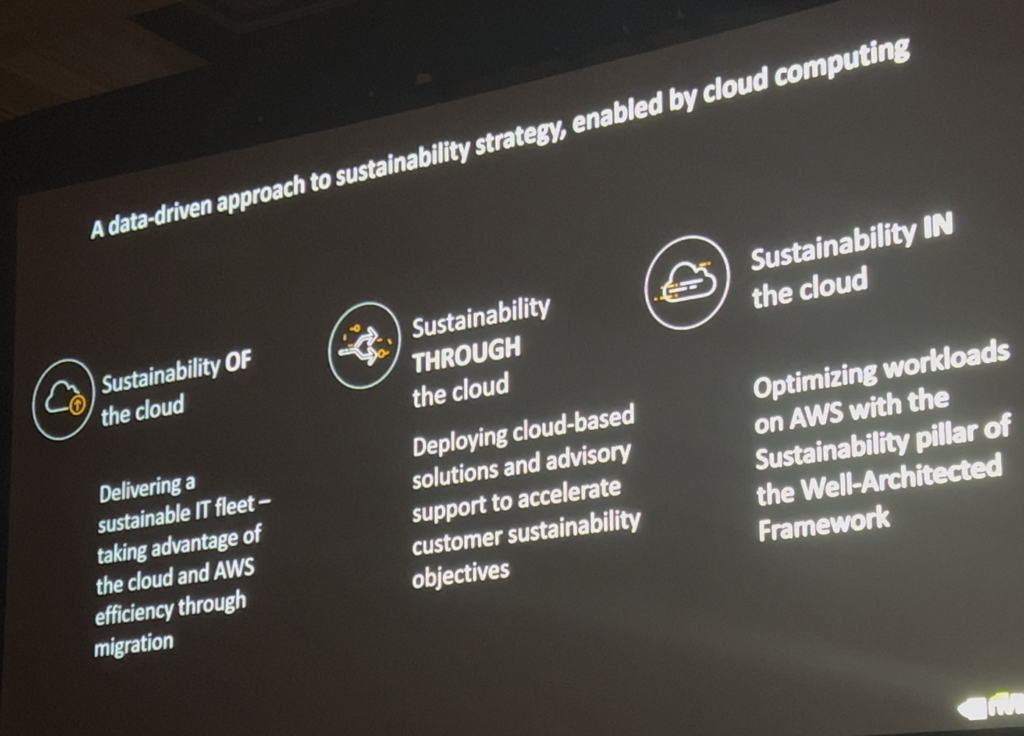

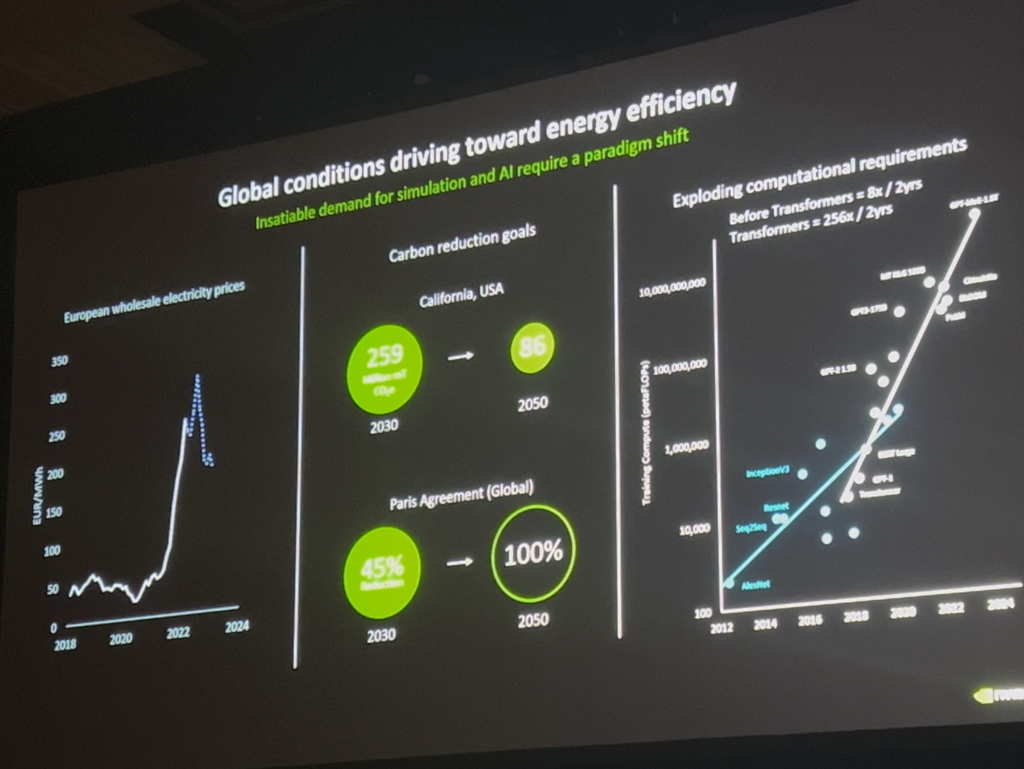

持続可能性と効率性

サステナビリティは現在、クラウドコンピューティングとデータセンターの運営において不可欠な要素となっています。 NVIDIAは、Blackwellアーキテクチャを通じてパフォーマンスを維持しながらエネルギー消費を減らすことに成功していると話しています。特に、液体冷却技術は従来の空気冷却よりも効率的であり、データセンターの全体的な消費電力を大幅に削減するのに貢献しています。これは、消費電力を最適化しながら同時スループットを向上させる効果を提供し、これらの技術革新は、企業が環境への影響を最小限に抑えながら高性能コンピューティングを使用できるようにします。 AWS との協力は、これらのサステナビリティ戦略をクラウド全体に拡大する上で重要な役割を果たしていると考えられています。

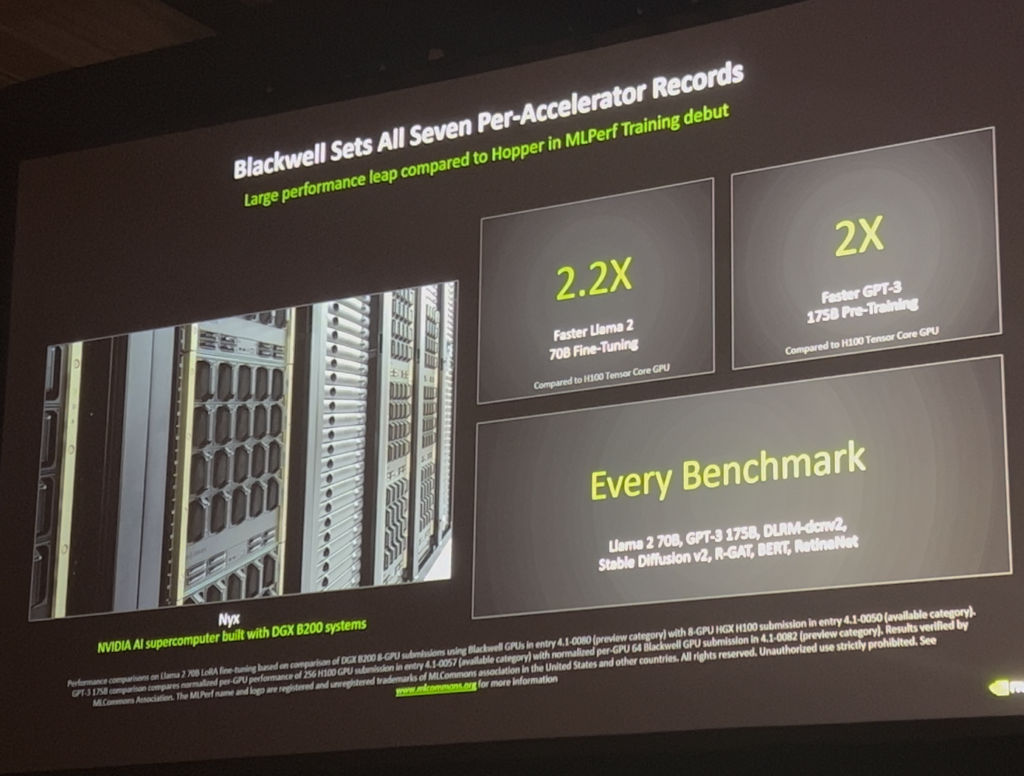

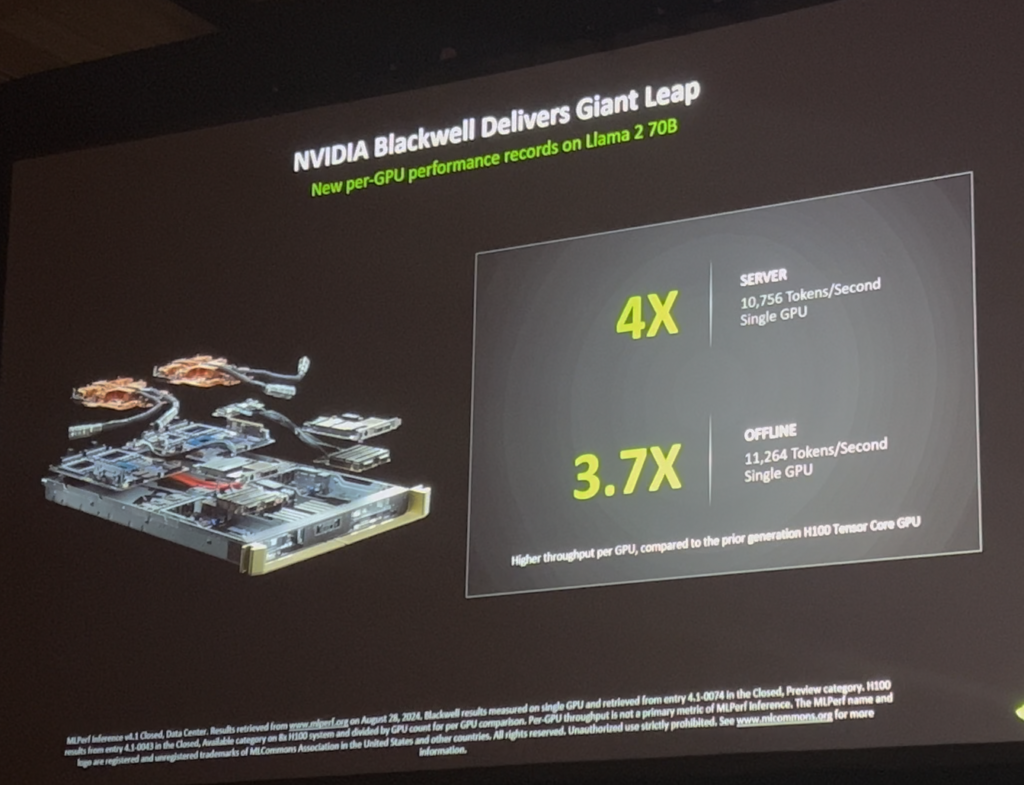

Blackwellアーキテクチャの革新

NVIDIAのBlackwellアーキテクチャは、Tensor Coreのパフォーマンスを拡張し、FP6やFP4などの追加の精度をサポートしています。これにより、大規模な言語モデルなどの複雑な計算で、より少ないリソースを使用しながらも高品質の結果を提供できるようになり、GPU間の通信帯域幅が以前よりも倍増し、最大1.8テラバイトの帯域幅でGPU間のデータ交換が可能という。これにより、トレーニングと推論の両方でより速い結果が得られ、複数のGPUが同時に作業を実行するときに発生するボトルネックを最小限に抑えることができると話しています。また、この技術的発展はAIモデルの大規模な拡張を可能にし、新しいAIアプリケーションケースを開発するために不可欠な基盤を提供すると述べています。

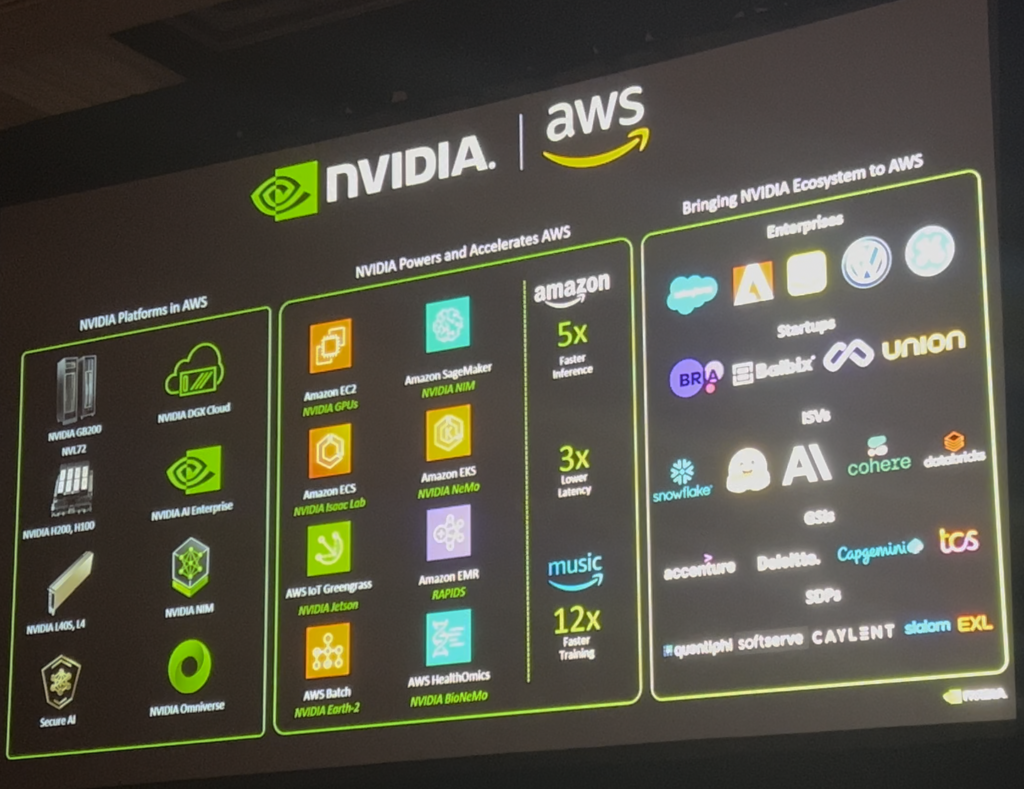

AWSとの連携

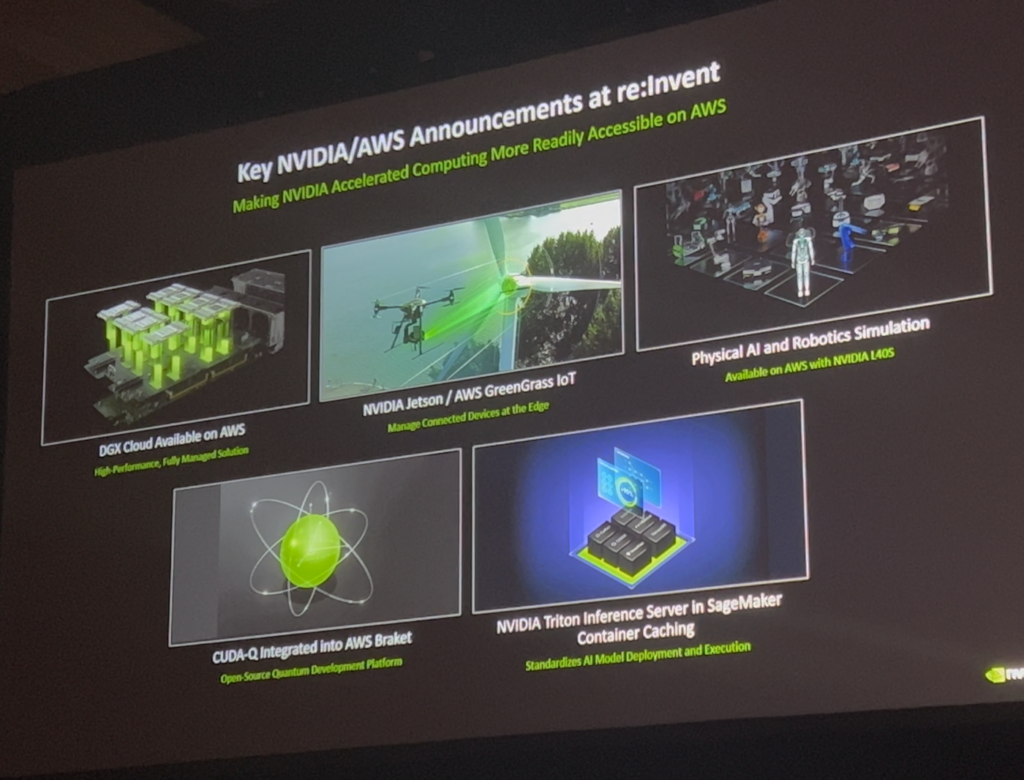

AWS は NVIDIA GPU を活用したさまざまなインスタンスを提供し、これによりクラウドで AI モデルの開発とデプロイをよりシンプルかつ効率的にするという。 DGX Cloudなどのサービスにより、企業は独自にインフラストラクチャを構築せずにAIアプリケーションを簡単にデプロイでき、さらにNVIDIAのソフトウェアスタックはAWSのSageMaker、Braket、Bedrockなどのサービスと統合されていると話しています。この統合は、開発者がAIモデルをより簡単に実験し、実稼働環境に導入し、さまざまなデータ分析タスクを実行するのに役立ちます。この協力は、NVIDIAとAWSがAIイノベーションをリードする重要なパートナーシップを形成していることを示しています。

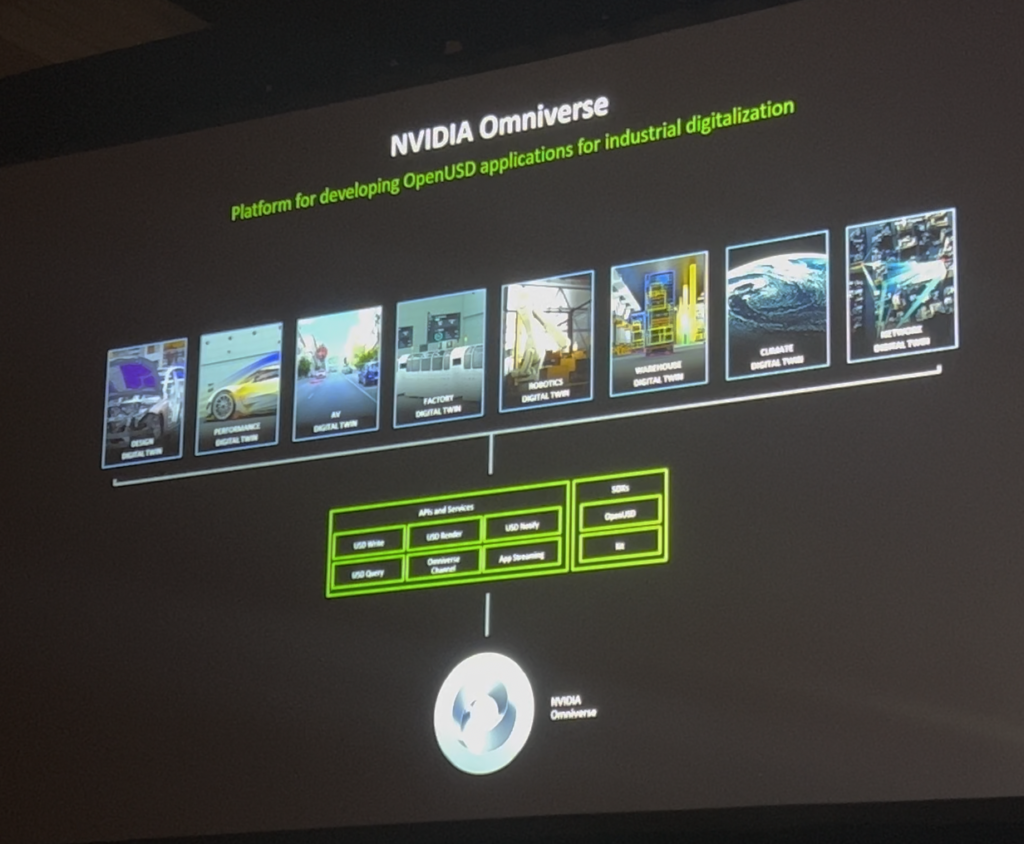

Omniverseとデジタルツイン

NVIDIA Omniverseは、3Dモデリングと物理ベースのシミュレーションを組み合わせて、デジタルツイン環境を提供すると言います。この技術は、工場、倉庫などの物理空間を仮想環境でシミュレートし、運用効率を事前に検証できるようにしています。たとえば、物流倉庫でロボットの経路を最適化したり、工場の施設の配置を変更する前に最適化されたレイアウトを確認したりできます。 Omniverseは、コラボレーション機能も提供し、複数の利害関係者が同時に設計とテストを進めることを可能にし、AWSを介してこれらのシミュレーション環境を簡単にデプロイして活用できると話しました。

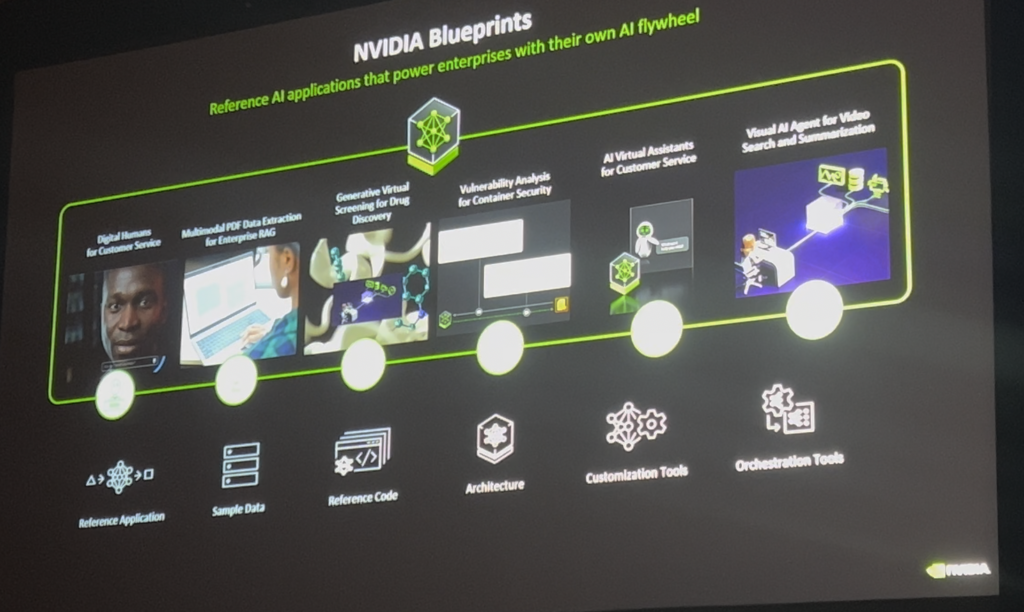

新しいソフトウェアとツール

NVIDIAは、NIM(NVIDIA Inference Microservice)やBlueprint Agentsなどのツールを使用して、開発者がAIアプリケーションを迅速にデプロイして効率的に運用できるようにします。 NIMは事前コンテナ化されたAIモデルで、数回のクリックで簡単に配布できるというのが大きな利点だと考えられます。 Blueprint Agentsは、特定の用途に合わせたAIアプリケーションを開発者がすぐに使用できるように設計されたツールであり、これらのツールは、特にAI開発経験が不足している企業に大きな価値を提供し、初期コストを削減し、時間効率を高めると話しています。

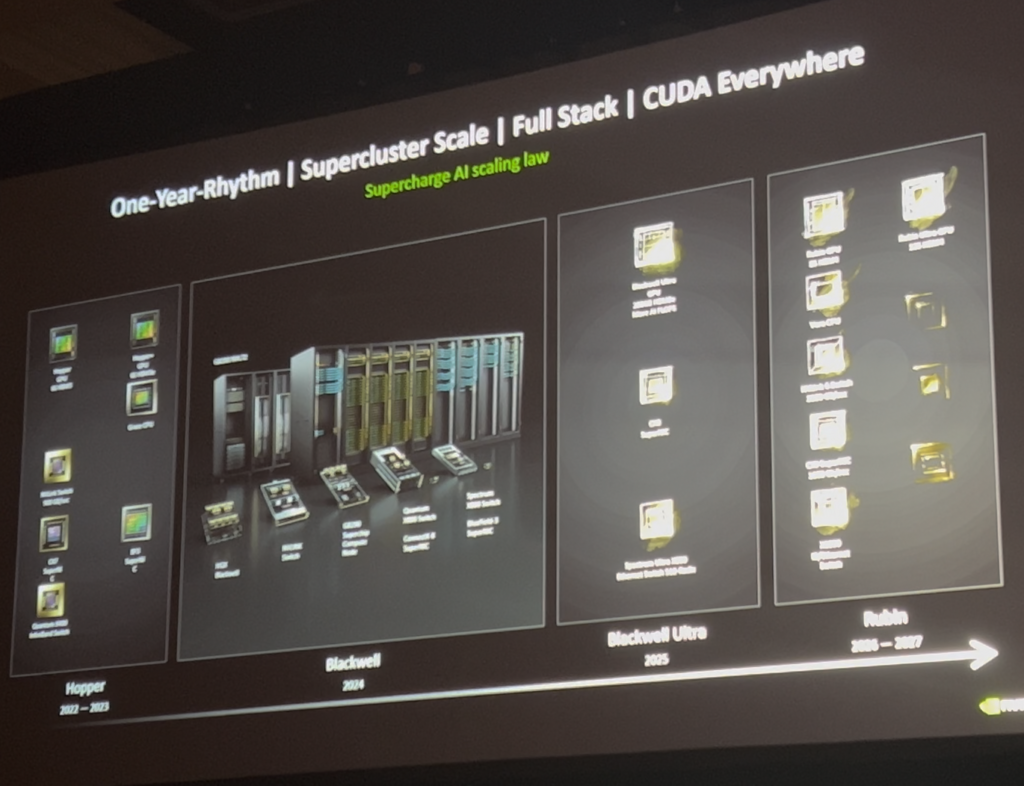

今後のロードマップ

NVIDIAは、毎年新しいGPUアーキテクチャを導入し、AI技術の継続的な発展をリードしているそうです。 Blackwellの後には、Blackwell Ultra、Ruben、Ruben Ultraなどの新しいプラットフォームが計画されています。また、ARMベースのCPUとネットワーク技術の発展により、データセンター規模での効率性を最大化し、この継続的なイノベーションがAIの研究開発の新たな可能性を開くことを見出しました。

まとめ

今回のセッションでは、NVIDIAとAWSの協力を通じて、生成型AIと高性能コンピューティング技術がどのように企業の問題を解決し、ビジネス成果を創出できるかを示したと考えられます。 BlackwellアーキテクチャとAWSの統合は、AIのパフォーマンスと効率性を最大化し、持続可能な方向に進んでいるようです。

特にOmniverseのような技術はデジタルツイン環境を通じて運用効率と革新の可能性を高めており、AI技術の実質的な導入を支援するために今後もNVIDIAとAWSは新しい技術とプラットフォームで企業がAIをより効果的に活用できるように協力続くと期待されます。

記事 │MEGAZONECLOUD Cloud Technology Center (CTC) Cloud FSI SA 3チーム チョン・ハフンSA

この記事の読者はこんな記事も読んでいます

-

Compliance & Identity re:Invent2024 Security StorageAWS re:Invent 2024 セッションレポート #STG306-R|Amazon S3に対するセキュリティパターンについての深堀り

Compliance & Identity re:Invent2024 Security StorageAWS re:Invent 2024 セッションレポート #STG306-R|Amazon S3に対するセキュリティパターンについての深堀り -

Cloud Operations Compliance & Identity re:Invent2024 SecurityAWS re:Invent 2024 セッションレポート #COP327|AWSベースの生成型AIの監査とコンプライアンスを加速

Cloud Operations Compliance & Identity re:Invent2024 SecurityAWS re:Invent 2024 セッションレポート #COP327|AWSベースの生成型AIの監査とコンプライアンスを加速 -

Compliance & Identity Networking re:Invent2024 SecurityAWS re:Invent 2024 セッションレポート #NET205|集中型ネットワーク・トラフィック・インスペクション:重要な洞察と学び

Compliance & Identity Networking re:Invent2024 SecurityAWS re:Invent 2024 セッションレポート #NET205|集中型ネットワーク・トラフィック・インスペクション:重要な洞察と学び