MEGAZONEブログ

LLMOps:The lifecycle of an LLM

LLMOps:LLMのライフサイクル

Pulisher : Cloud Technology Center キム・ジホ

Description : 大規模言語モデル(LLM)のライフサイクルを理解し、それを効果的に管理するための実践的なストラテジーを紹介するセッション

はじめに

大規模言語モデル(LLM)のライフサイクルを理解し、それを効果的に管理するための実用的な戦略を習得するためにこのセッションを選択しました。LLMを効果的に採用し、長期的に管理するための実用的なガイドを得ることができ、LLMの実装と維持を成功させるためのインサイトを得ることができることを期待しています。

セッションの概要紹介

大規模言語モデル(LLM)の利用が増加するにつれて、これらのモデルの開発、展開、および保守に新たな課題が生じています。 多くのMLOpsの事例がありますが、Foundationモデルには追加の考慮事項が必要です。この chalk talk では、組織内で大規模にLLMを採用し、そのモデルを長期的に維持するための実用的なアドバイスを提供します。

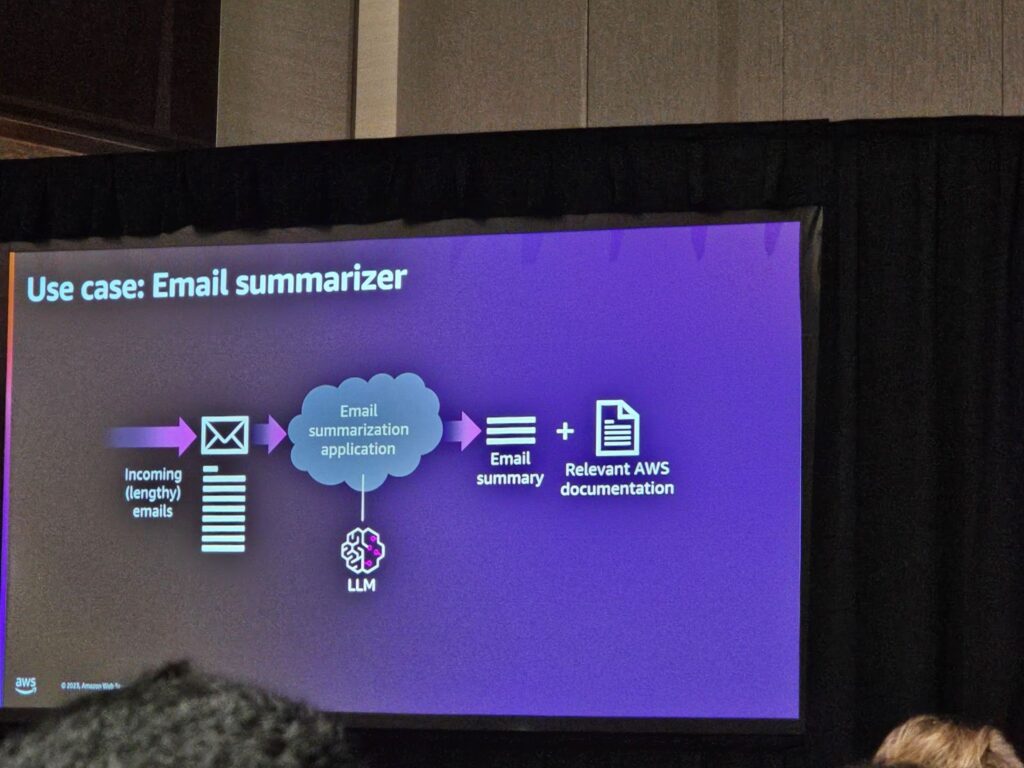

MLOpsを本格的に説明する前に、ユースケースについて話しました。

新しいアプリを構築する方法ですが、講演者は5年前にメールサマリーアプリを作成しようとした経験があるそうです。

どのような新しいプロジェクトを始める際には、常に小さな規模で始めるのですが、これがどのように拡大するか、またはどのような方向に進みたいかを常に考え、将来のアプリケーションは何になるかを考えます。

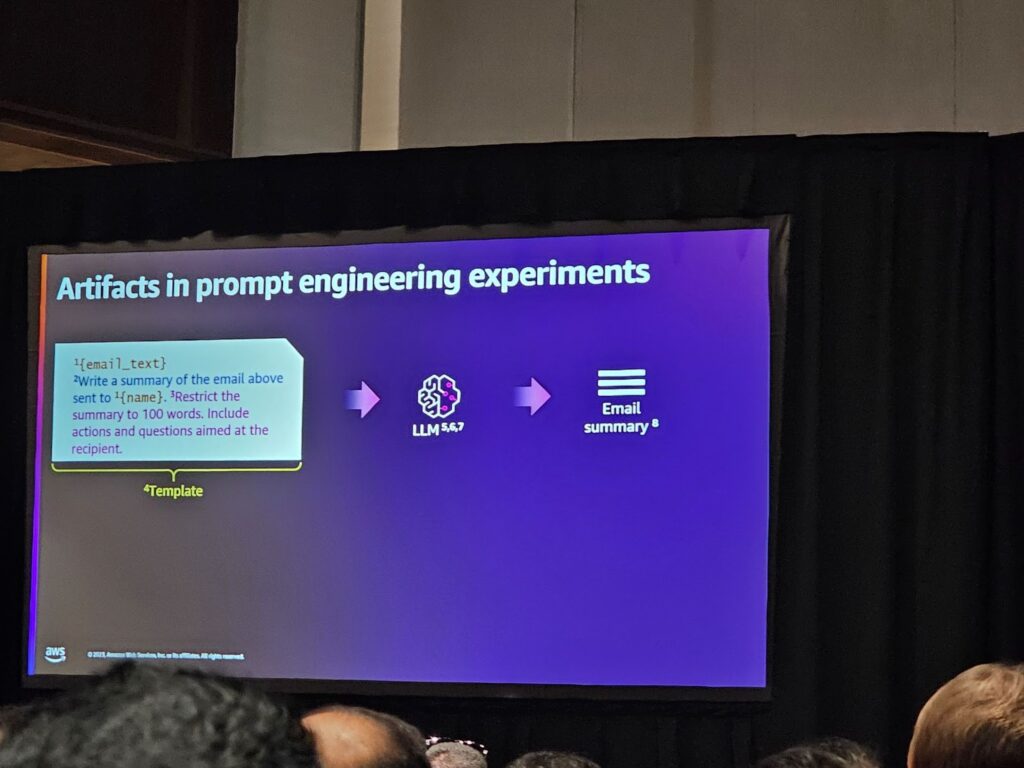

下の画像は、メールが受信され、要約された内容がユーザーに送り返される仕組みの図です。

長いメールを受け取ったときに、要約されることに加えて、メールに関連するドキュメントへのリンクも取得できたらいいのでは?というアイデアを考えることができます。

したがって、MLOPSは機械学習作業であり、人、技術、プロセスの交差点と言えます。

また、FMはFoundation Model Operationsの略で、さまざまな異なるドメインで生成されたAIソリューションを効率的/成功させることを主な目標としています。

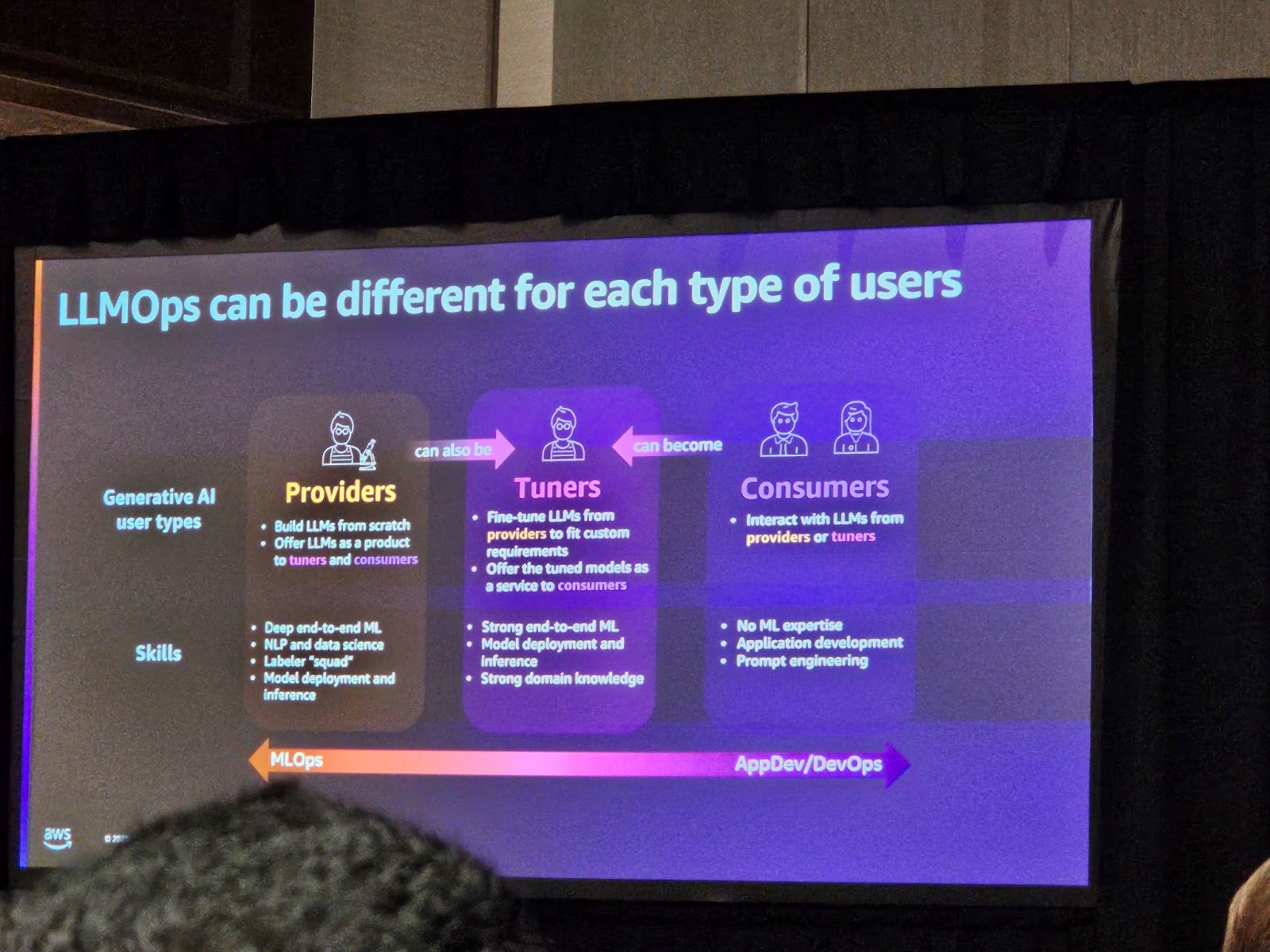

ユーザーには3つのタイプがあります。

1.モデル提供者:LLMを構築できる、専門知識を持つ大規模な組織/リソースを提供されるスタートアップなど。彼らは膨大な量のデータを収集する能力を持っています。

2.モデル提供者の反対側の消費者:ビデオアプリを作成し、モデルを簡単に使用したい個人またはチーム。

3.モデル提供者と消費者の間のTuner(チューナー):モデル提供者が提供するモデルを得ることができるチームまたは個人。

モデルを作成する人は、変数の最適化、モデルの配布などの作業を行います。一方、消費者はこのような作業を行う必要がないため、消費者は簡単にモデルを使用できますが、消費者が解決しなければならない問題があり、どのモデルを使用するかを選択する必要があります。 また、アプリケーションが正常に動作しているかどうかをモデルを監視し続ける必要があります。

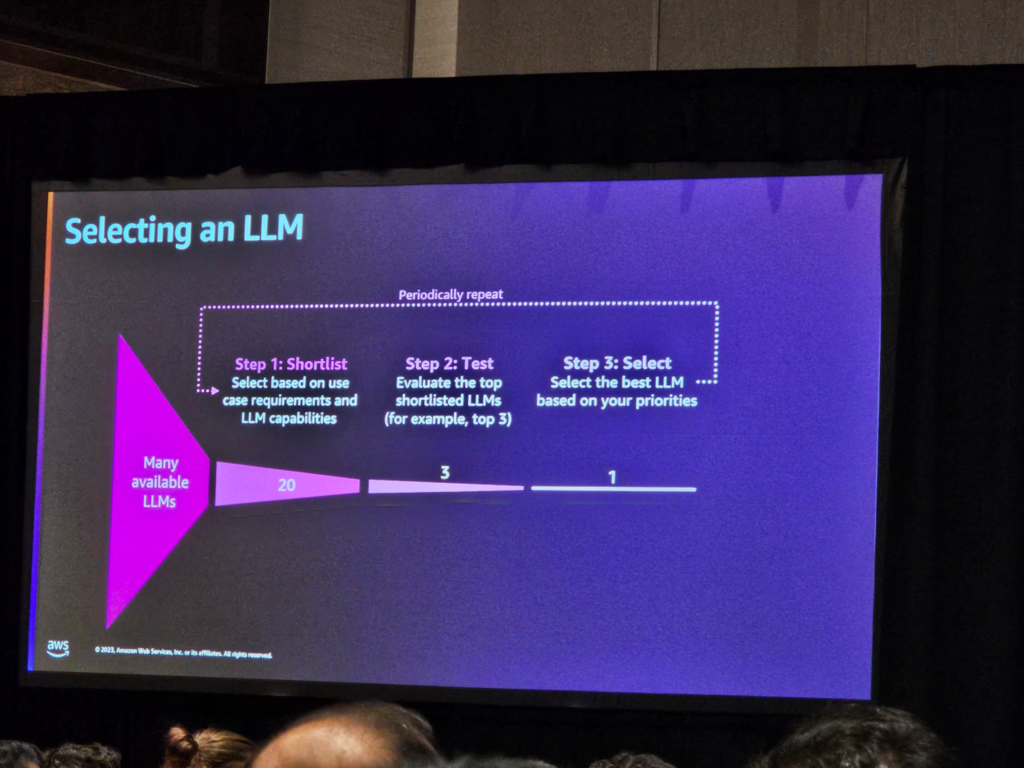

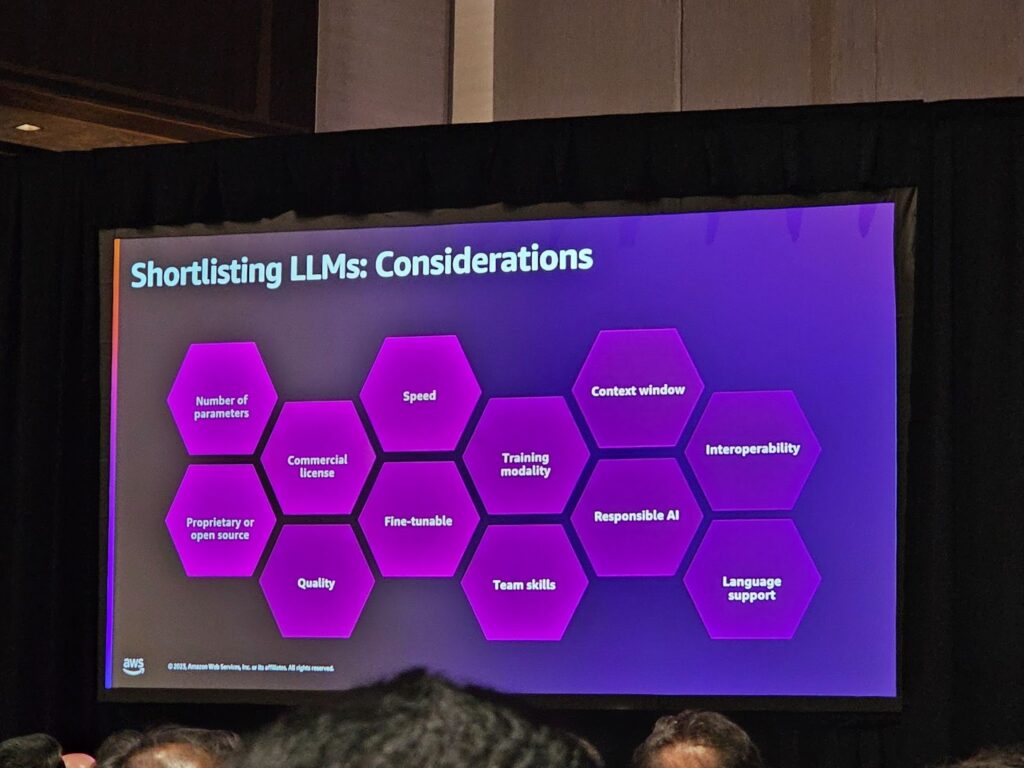

このため、消費者が大規模な言語モデルを選択するためのアプローチを説明しました。

まず、ユースケースに適したモデルを選択するための確認段階を行い、その後、特定の数のモデルを選択し、それらをテストするためのデータセットをコンパイルして、どのモデルが私たちのユースケースに最も適しているかを判断します。このため、定量的な分析を行い、定期的にこのプロセスを繰り返し、新しいモデルを検討できるようにします。

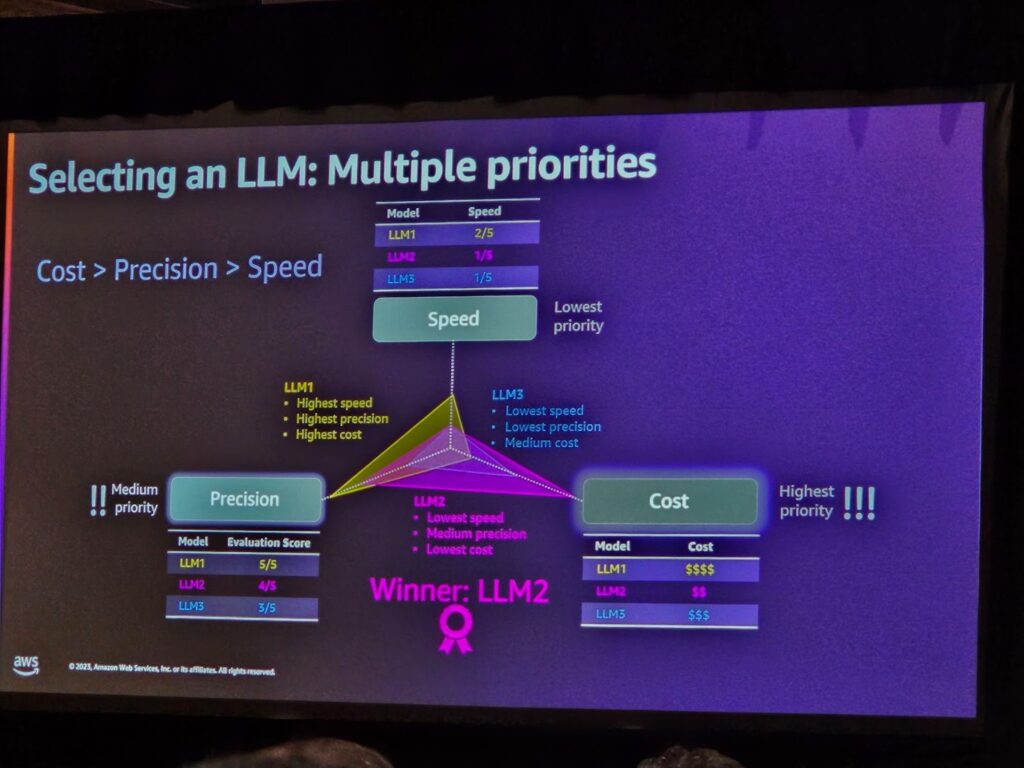

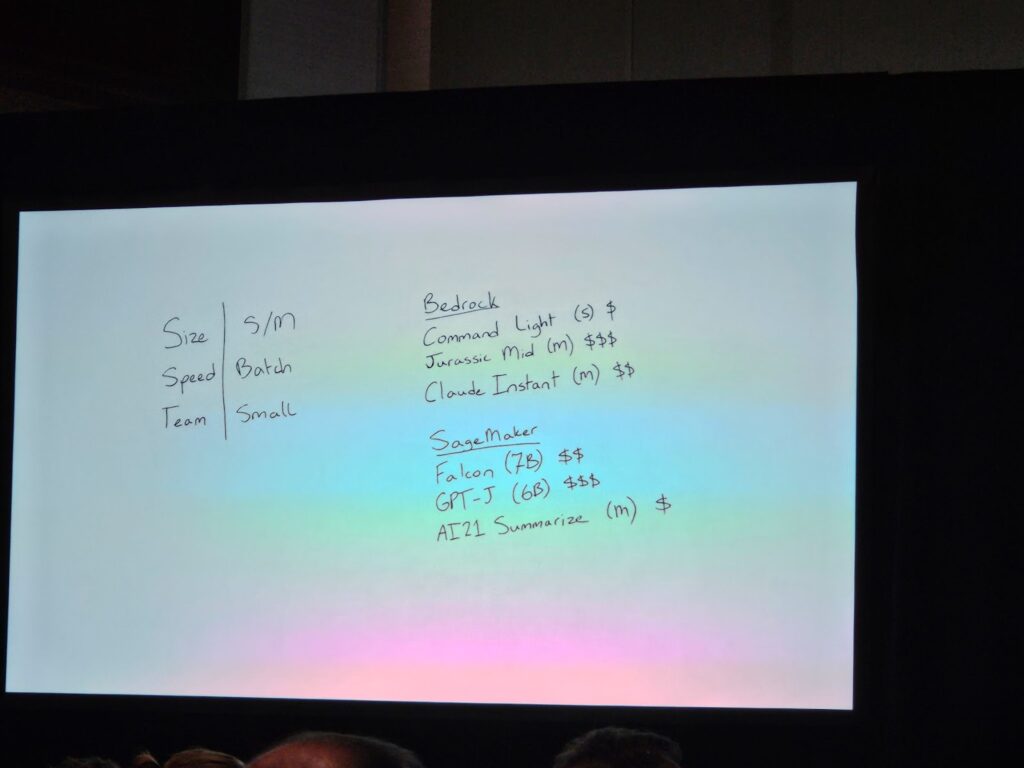

3つの基準、すなわち規模、スピード、そしてチームの優先順位を考慮してモデルを選択する方法を提案しました、

開発スピードを優先し、バッチ処理を通じて問題を解決し、実際の使用事例に応じてモデルを選択する方法の説明とモデルの詳細、価格、そして入力および出力トークン価格を考慮して複数のモデルを比較し、トークンベースの価格設定を通じてモデルを選択する方法が提案されました。

これに基づいて、Bedrock、Claud、Stagemaker内のモデルの中から最も適したモデルを選択し、最終的にFalcon 7b GPJモデルを選定する過程が紹介されました。

セッションを終えて

セッションを通じて、LLMのライフサイクル全体についての理解が深まり、このようなモデルを開発し、維持するための課題に対する認識が高まりました。

特に、一般的なMLOpsに必要な考慮事項に加えて、基本的なモデルに必要な追加的な考慮事項と実用的なアドバイスを得ることで、組織内でLLMを効果的に実装するのに役立ちました。

このセッションは、AWSパートナーを対象としたセッションであり、AWSベースでLLMを適用するために不可欠な戦略的指針とツールに関する洞察を得ることで、パートナーシップのプロジェクトに即座に活用することができると期待されます。 また、長期的なモデル管理に関する実用的なガイドを通じて、モデルの性能と安定性を維持するのに役立つと予想されます。

この記事の読者はこんな記事も読んでいます

-

Compute re:Invent 2023Apple on AWS: Managing dev environments on Amazon EC2 Mac instances(Apple on AWS:Amazon EC2 Macインスタンスで開発環境を管理する)

Compute re:Invent 2023Apple on AWS: Managing dev environments on Amazon EC2 Mac instances(Apple on AWS:Amazon EC2 Macインスタンスで開発環境を管理する) -

Compute re:Invent 2023Optimizing for cost and performance with AWS App Runner(AWS App Runnerによるコストとパフォーマンスの最適化)

Compute re:Invent 2023Optimizing for cost and performance with AWS App Runner(AWS App Runnerによるコストとパフォーマンスの最適化) -

Partner Enablement re:Invent 2023Migration and modernization: Become your customer’s strategic partner

Partner Enablement re:Invent 2023Migration and modernization: Become your customer’s strategic partner