MEGAZONEブログ

SaaS and AI/ML:Inside a multi-tenant AI/ML solution

SaaSとAI/ML:マルチテナントAI/MLソリューションの中身

Pulisher : Cloud Technology Center キム・ジホ

Description : SaaSアプリケーション向けの効果的でスケーラブルなAI/MLアーキテクチャを構築するワークショップセッション

はじめに

AI/MLベースのSaaSソリューションは、テクノロジー環境に不可欠な要素になりつつあり、プロバイダーがマルチテナント環境の複雑さをどのようにナビゲートしているかを理解するためにこのセッションを選択しました。SaaSアプリケーション向けの効果的でスケーラブルなAI/MLアーキテクチャを構築するための実用的な洞察を得ることができることを期待しています。

セッションの概要紹介

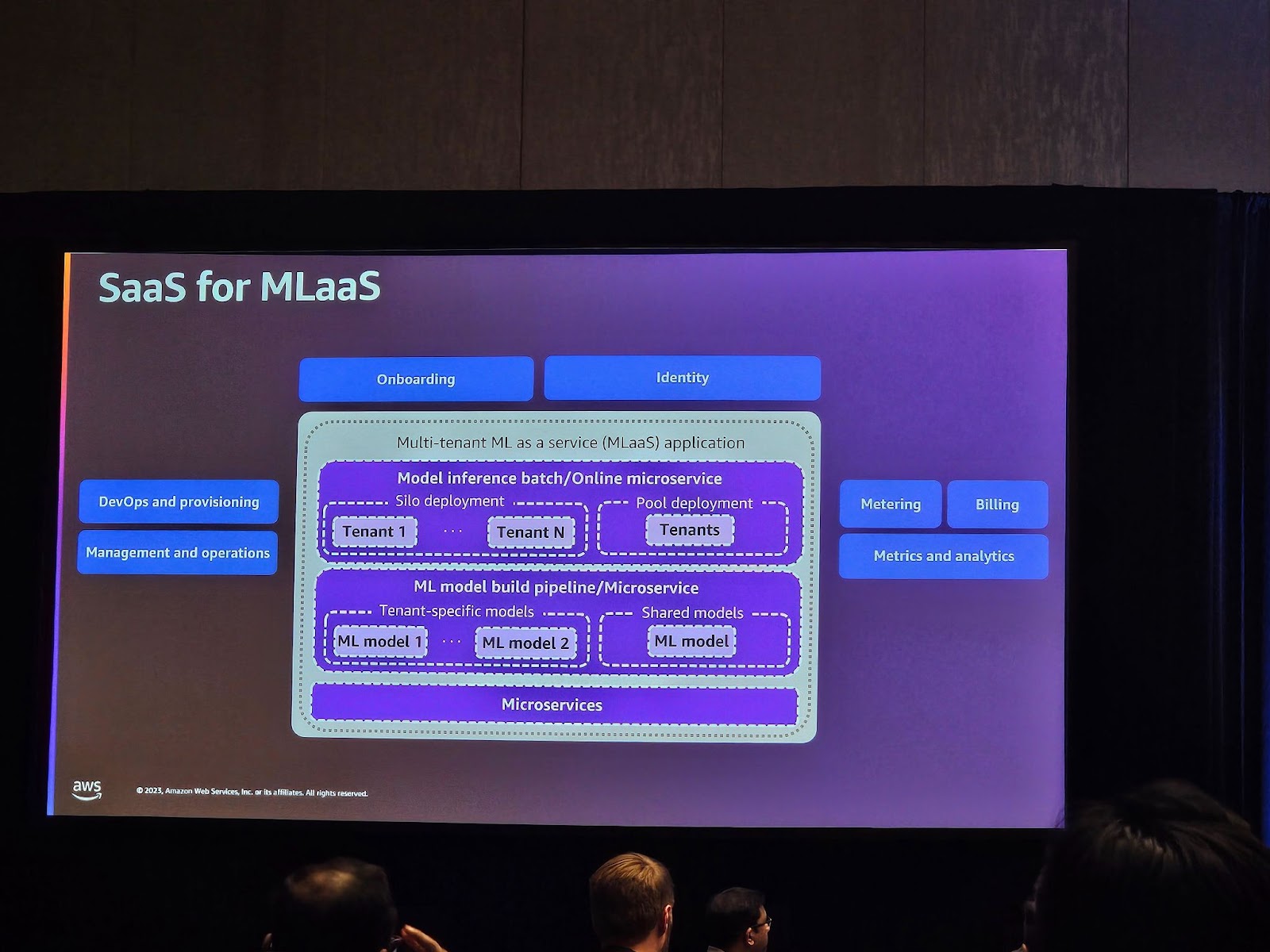

SaaSプロバイダーは、AI/MLを製品の一部として活用するソリューションをどんどん作っています。MLモデルは、新しい機能を導入し、既存のエクスペリエンスを充実させ、差別化を促進するために使用されます。課題は、マルチテナント環境でAI/MLモデルをサポートし、推論する方法を見つけることです。

テナントモデルの共有や専用化、テナント推論の展開には、さまざまな戦略があります。

このワークショップでは、テナントごとのモデルトレーニング、マルチテナント推論の公開、テナントAI/MLリソースの分離など、さまざまなAI/ML SaaSアーキテクチャ戦略をサポートするマルチテナントソリューションを構築する方法を学びます。

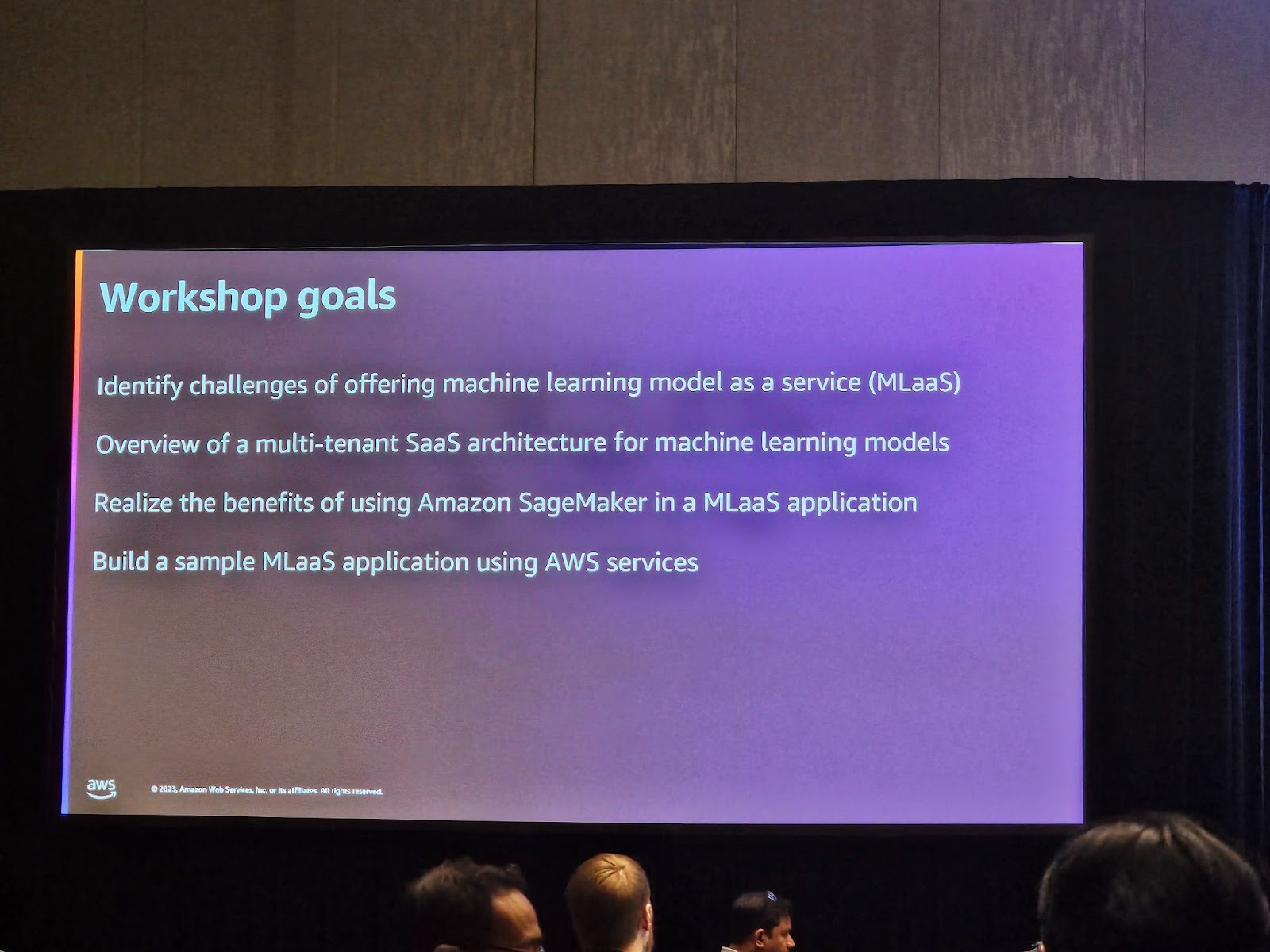

セッションの目的は以下の通りです。

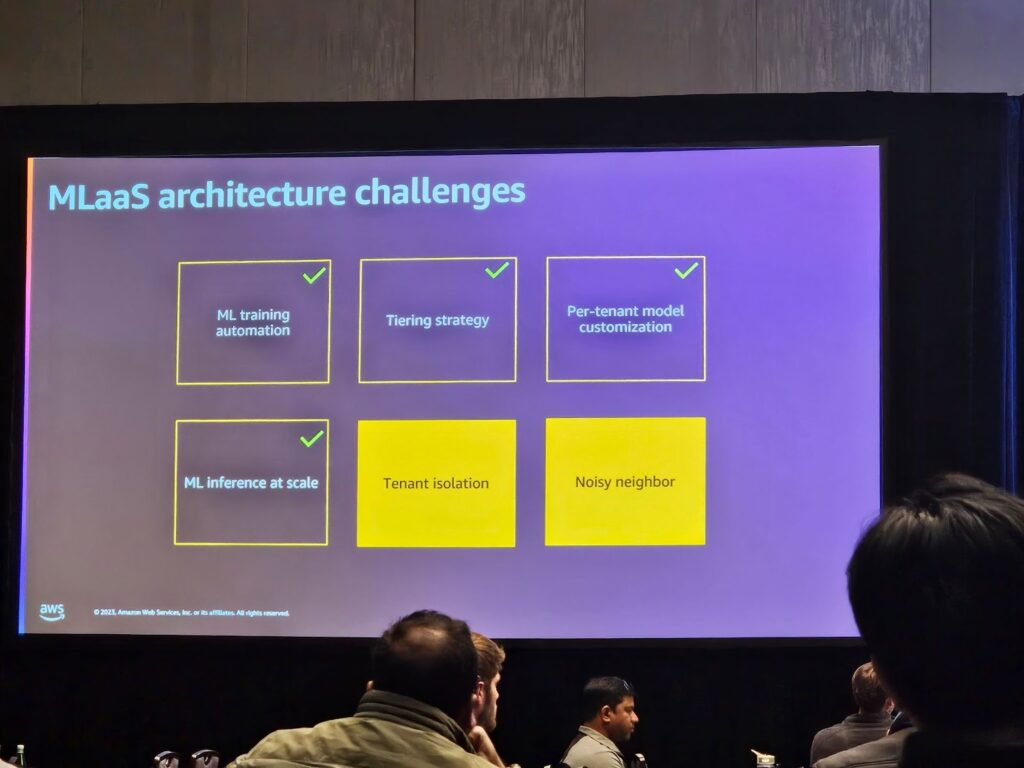

1.機械学習モデルをサービスとして提供する(MLaaS)際の課題を特定する。

2.機械学習モデルのためのマルチテナントSaaSアーキテクチャの概要を理解する。

3.MLaaSアプリケーションでAmazon SageMakerを使用するメリットを理解する。

4.AWSサービスを活用したサンプルMLaaSアプリケーションを構築する。

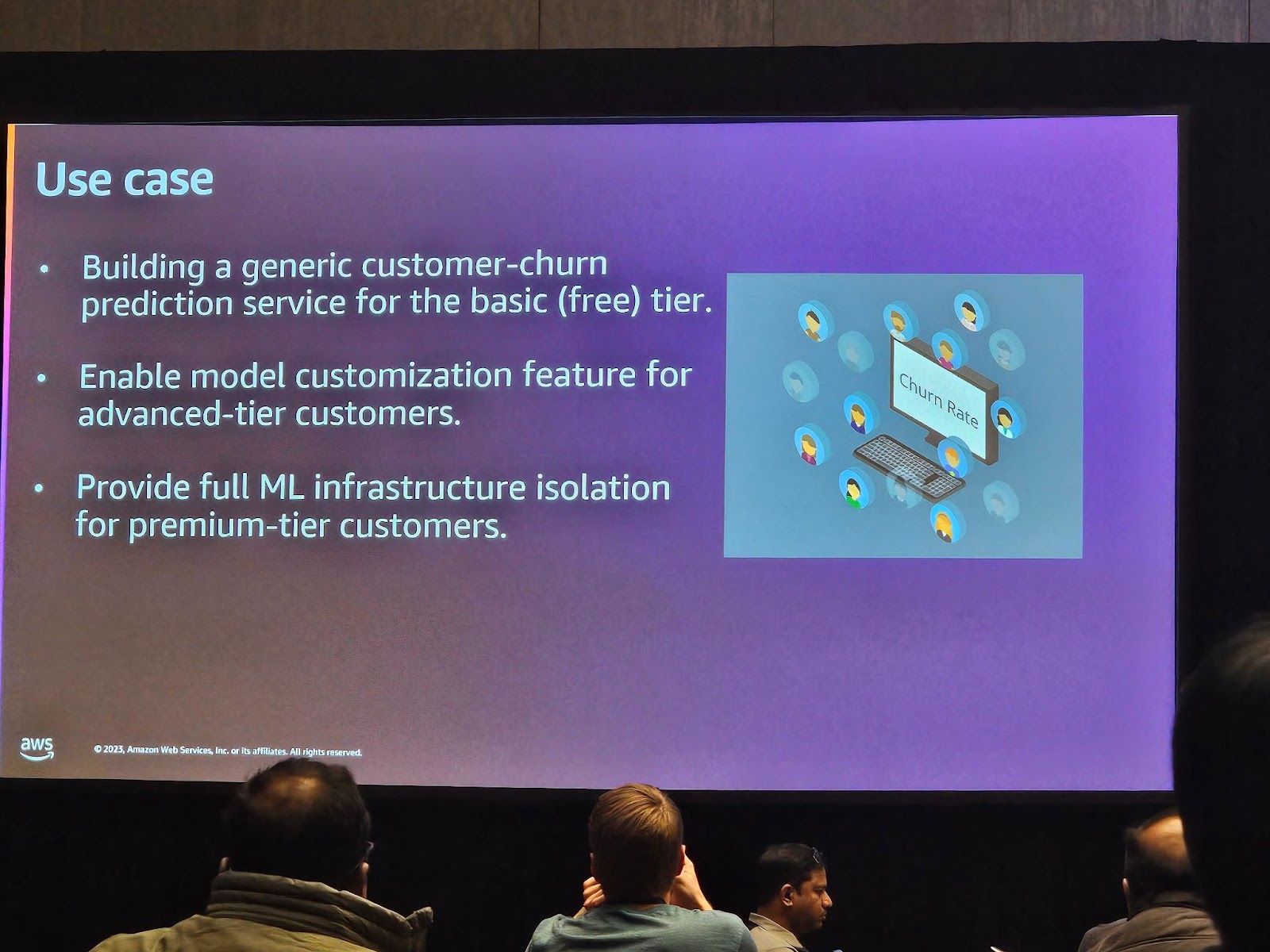

使用事例は以下の通りです。

・一般的な顧客離脱予測サービスの構築

・モデルのカスタマイズ機能を有効にする

・完全な機械学習インフラストラクチャの分離を提供

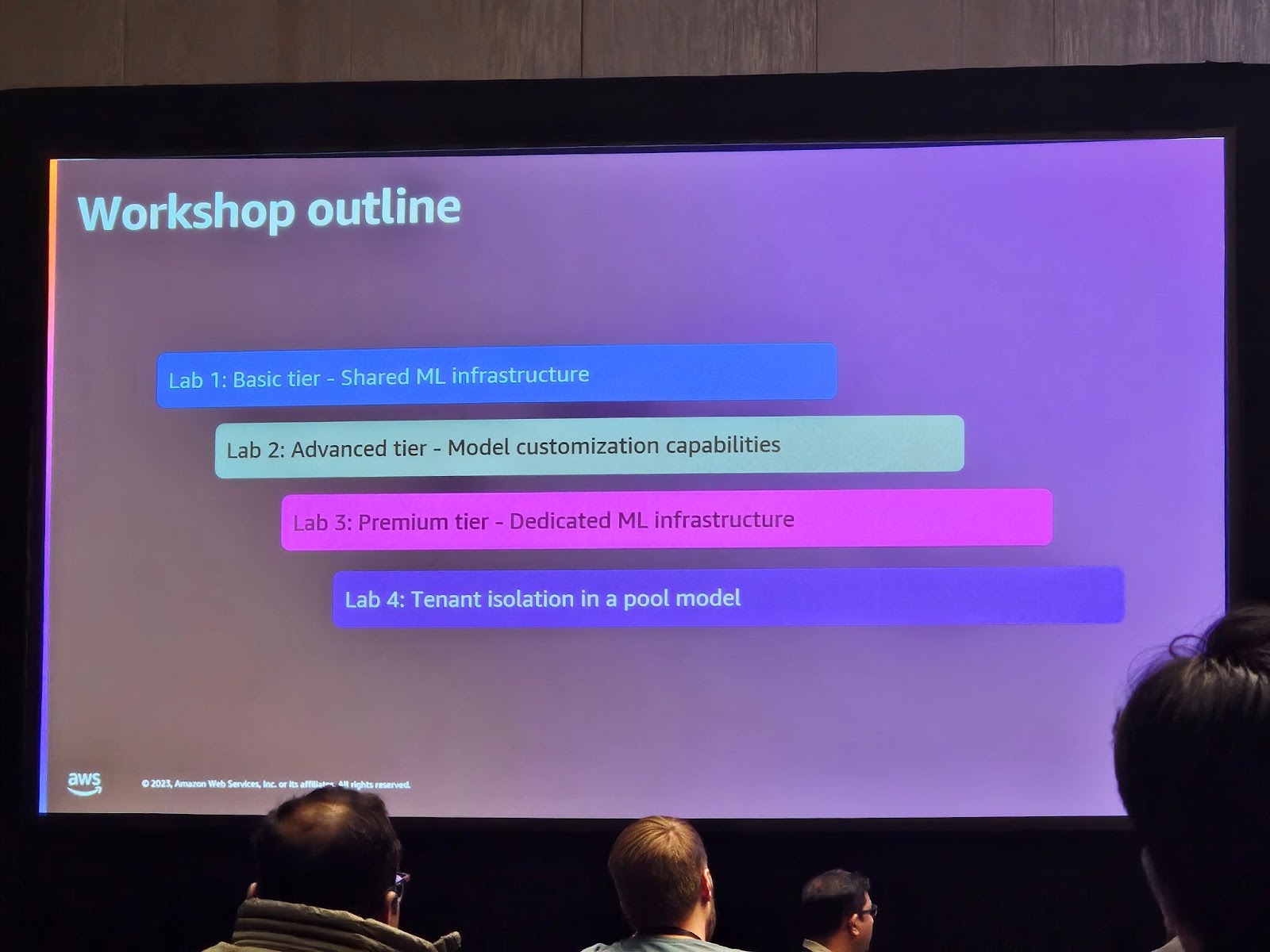

各実習は次のようなテーマで行われます。

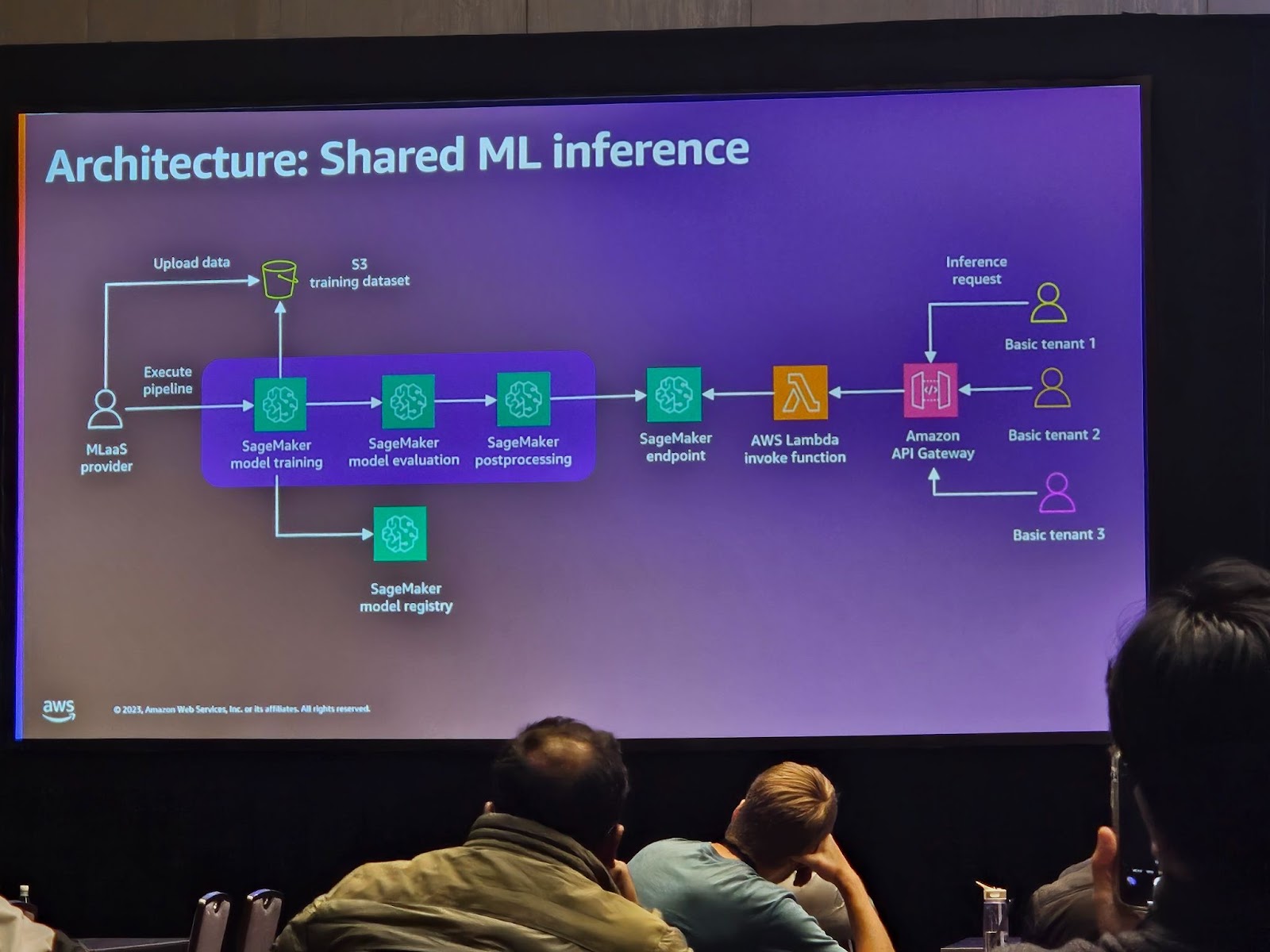

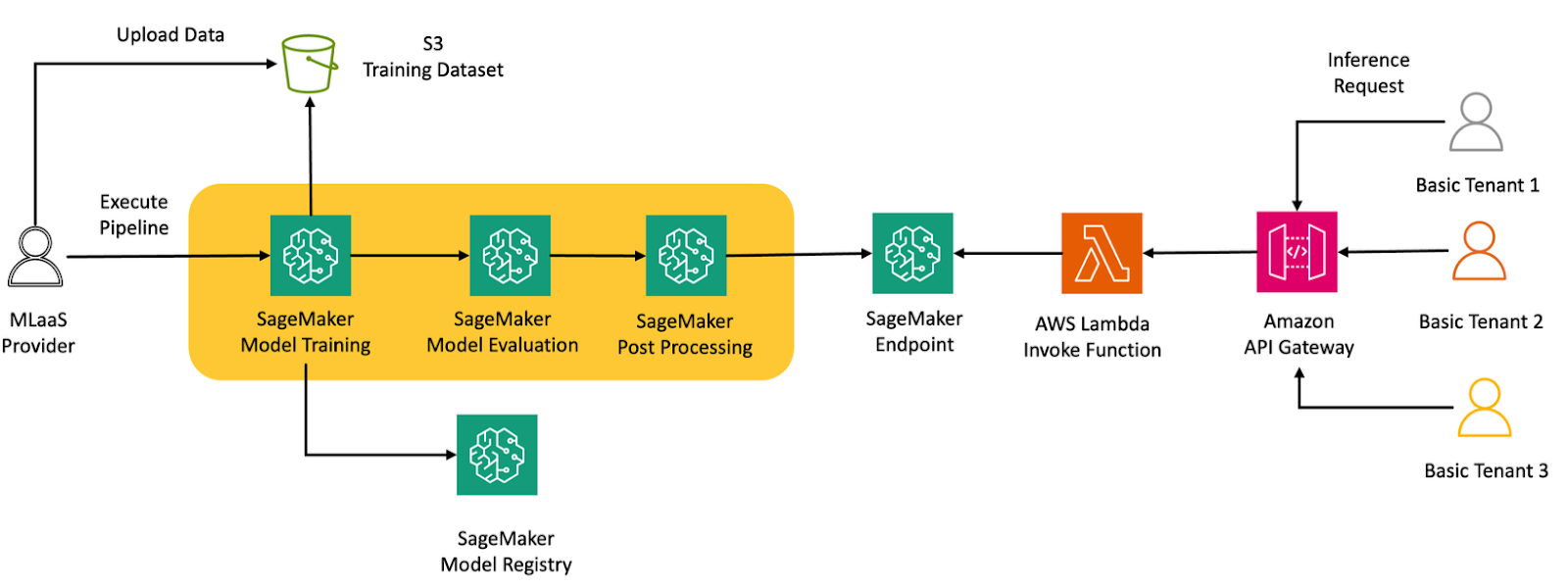

Lab 1 – Basic Tier: Shared ML Infrastructure:コストを最適化するために共有リソースを使用する基本的なティアを紹介します。 また、SageMakerパイプラインを紹介し、モデルを学習、評価、登録するMLパイプラインを構築する方法を説明します。

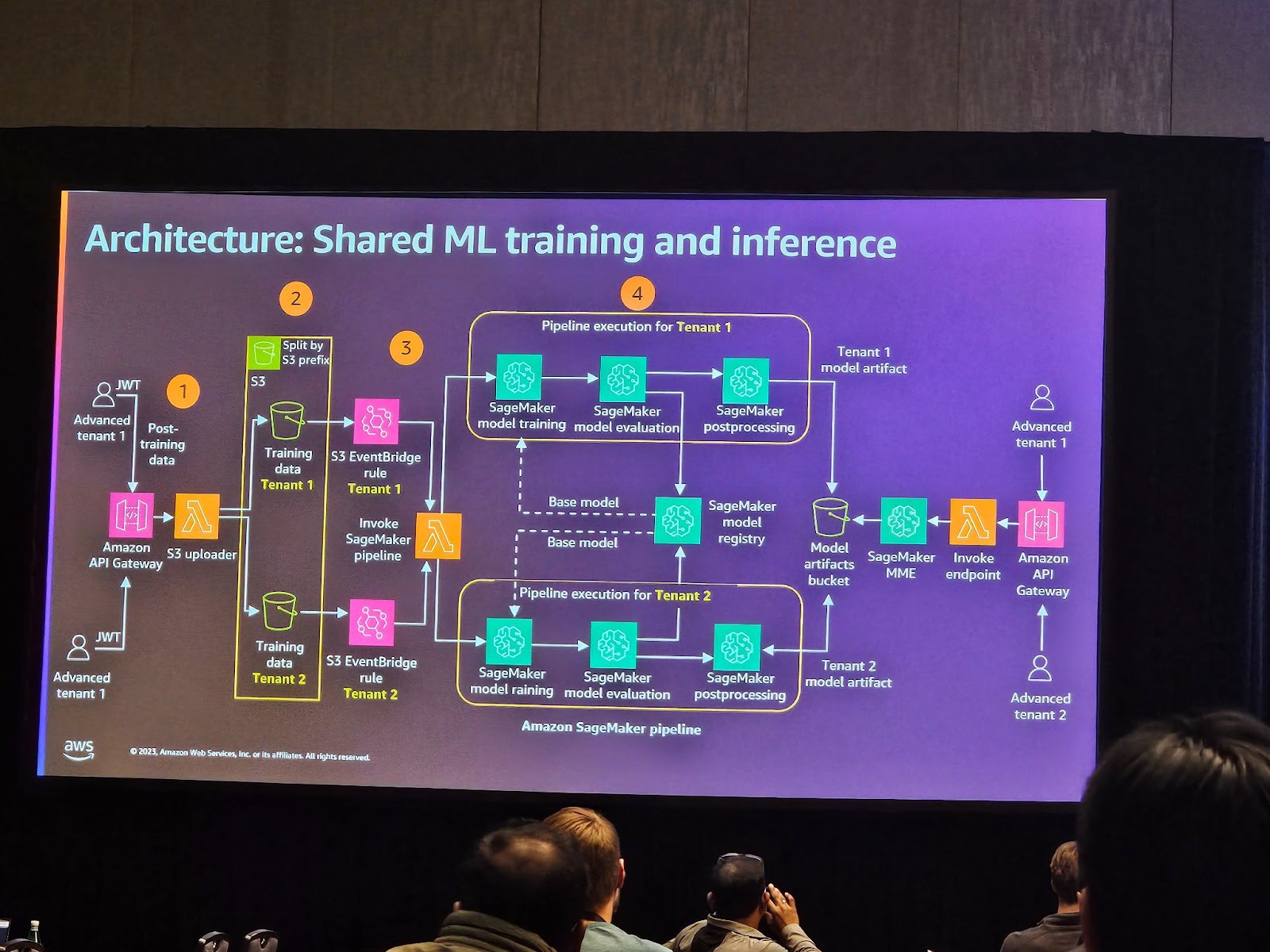

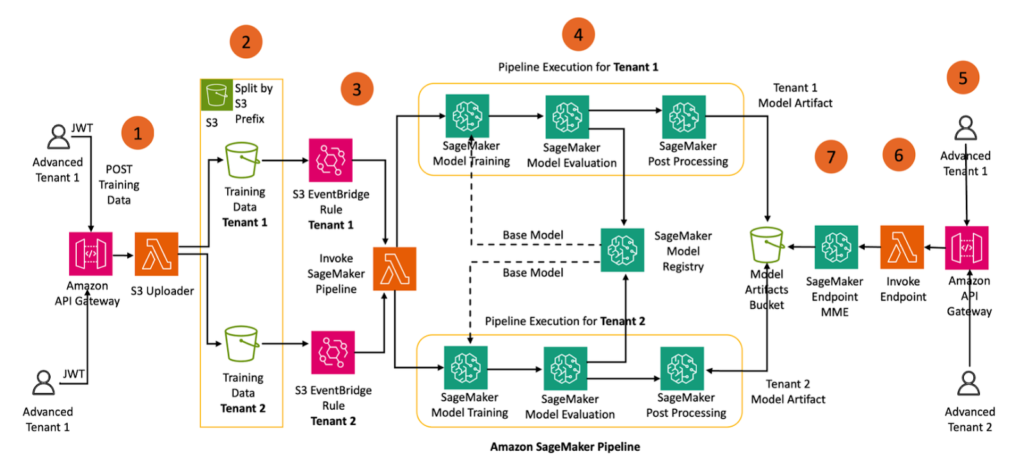

Lab 2 – Advanced Tier: Fine-Tuning Capabilities: モデルを微調整するために共有アーキテクチャを使用する高度な階層を紹介します。 また、SageMaker Multi-Model Endpoints (MME)を使用して、複数のモデル推論エンドポイントを共有リソースプールでホストする推論アーキテクチャを紹介します。

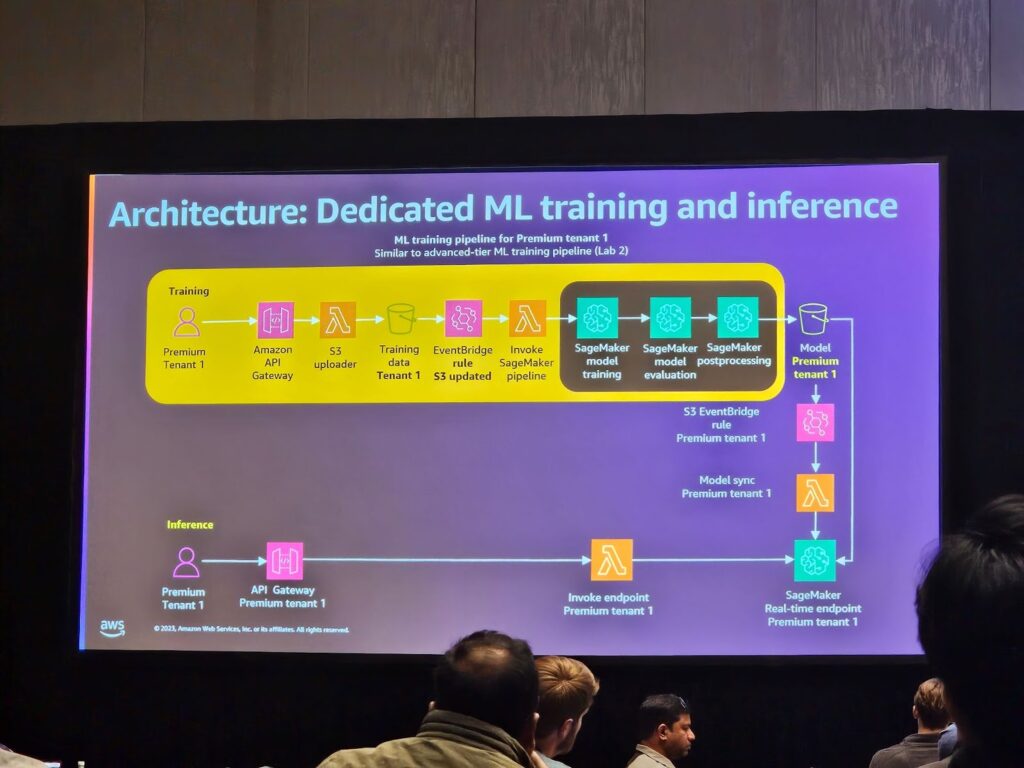

Lab 3 – Premium Tier: Dedicated ML Infrastructure:モデルを微調整するための専用アーキテクチャを提供するプレミアムティアを紹介します。 また、SageMakerリアルタイム推論エンドポイントを使用した専用推論アーキテクチャを紹介します。

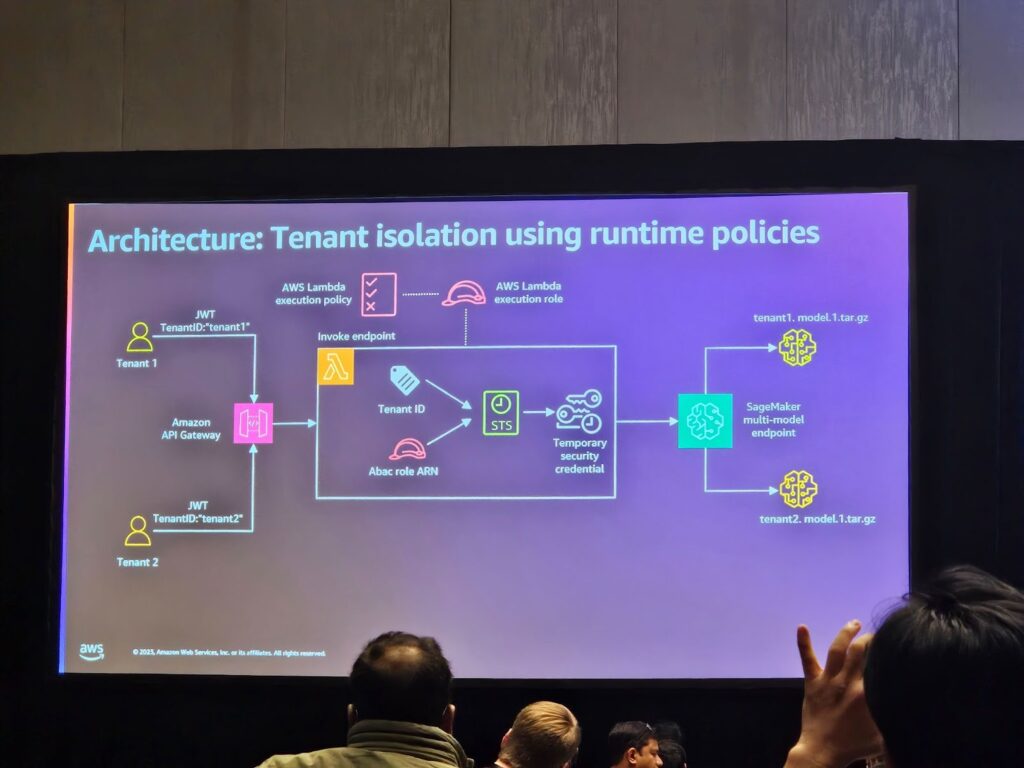

Lab 4 – Tenant Isolation in a pooled model:共有アーキテクチャでIAM属性ベースのアクセス制御(ABAC)アプローチを使用して、テナントの分離を強制する方法を紹介します。

SaaSプロバイダーは、徐々にAI/MLを活用したソリューションを提供しています。MLモデルは、新しい機能の導入、既存のエクスペリエンスの向上、差別化を促進するために使用されます。

ここで課題となるのは、マルチテナント環境でAI/MLモデルと推論をサポートする方法を見つけることです。 本ワークショップでは、この問題を探求し、さまざまなAI/ML SaaSアーキテクチャ戦略をサポートするマルチテナントソリューションを構築します。

Lab 1

AnyCompanyは、毎月のトレーニングを受け、最新の取引データを統合していないMLモデルを含む機能が制限された無料層を導入することで、存在感を高めることを目指しています。機械学習サービスとしての機械学習(MLaaS)プロバイダーの主な目標は、その機能を紹介し、より多くのユーザーを上級およびプレミアムサブスクリプション層にオンボーディングすることです。 この層の費用対効果を確保するために、MLaaSプロバイダーは共有モデルと推論サービスを活用する必要があります。

ラボ1の目標は次のとおりです:

SageMakerモデルビルドパイプラインを設定し、一般的なMLモデルを構成、トレーニング、評価、登録する。

すべてのベースレイヤーテナントがアクセスできるSageMaker MLエンドポイントに汎用MLモデルをデプロイする。一般的なモデルの提供を促進するために使用されるAWSサービスを確認し、MLaaSコントロールプレーンを通じて2つの基本層テナントをオンボーディングし、テナント登録情報を調査します。

モデルを呼び出して推論応答を取得します。

Lab 3

.Advancedテナントがオンボーディングされると、一般的なモデル(基本階層と同様)を呼び出すことができますが、独自のデータセットに基づいてモデル(XGBoost)をカスタマイズすることができます。

このアーキテクチャのコアコンポーネントは、自動化されたマルチテナントMLモデル構築およびモデル登録パイプラインと、次の図に示すマルチモデルエンドポイント(MME)でテナントモデルをホストすることです。

セッションを終えて

このセッションを通じて、マルチテナントAI/MLソリューションを構築するために必要な様々な戦略と技術的側面について理解することができました。テナント別モデルトレーニング、マルチテナント推論、そしてテナント間のAI/MLリソースの隔離に関する実際の適用方法を学び、今後のプロジェクトでより効率的で安全なAI/ML機能を実装することができそうです。

この記事の読者はこんな記事も読んでいます

-

Compute re:Invent 2023Apple on AWS: Managing dev environments on Amazon EC2 Mac instances(Apple on AWS:Amazon EC2 Macインスタンスで開発環境を管理する)

Compute re:Invent 2023Apple on AWS: Managing dev environments on Amazon EC2 Mac instances(Apple on AWS:Amazon EC2 Macインスタンスで開発環境を管理する) -

Compute re:Invent 2023Optimizing for cost and performance with AWS App Runner(AWS App Runnerによるコストとパフォーマンスの最適化)

Compute re:Invent 2023Optimizing for cost and performance with AWS App Runner(AWS App Runnerによるコストとパフォーマンスの最適化) -

Partner Enablement re:Invent 2023Migration and modernization: Become your customer’s strategic partner

Partner Enablement re:Invent 2023Migration and modernization: Become your customer’s strategic partner